Solutions & Technologies

瞻博网络可以助您一臂之力

客户和合作伙伴现在可以在瞻博网络位于加利福尼亚州森尼韦尔总部的专有实验室中,验证其 AI 模型的性能和功能。

测试瞻博网络经 AI 优化的以太网是否足以媲美甚至超越 InfiniBand

客户现在可以针对自身用例,验证经 AI 优化的以太网交换机性能,亲自体验用于推理、训练和存储的全栈瞻博网络 AI 数据中心解决方案。使用 MLCommons® MLPerf BERT-large、DLRM、Llama 2 或自带模型 (BYOM),测试 AI 的性能和功能。

验证设计,确保成功

适用于全栈交换矩阵、GPU 和存储网络的瞻博网络验证设计 (JVD) 能够给客户十足信心,确保其 AI 群集已经过全面审查、测试,随时可以大放异彩。无需猜疑,即插即用。

AI 全生命周期管理和自动化

在设计、构建、部署持续 AI 运维流程并实现其自动化的过程中,可利用 Apstra Data Center Director 的交换矩阵管理和全生命周期自动化功能。Data Center Director 为客户提供更加灵活的招聘选择,在整个 AI 基础架构中实施端到端通用 NetDevOps 流程。

做好亲自体验的准备了吗?

填写此表格,报名访问实验室。

Ops4AI 实验室常见问题解答

Ops4AI 是什么?

我们的全新 Ops4AI 解决方案提供了极具影响力的增强功能,能够为客户带来卓越价值。Ops4AI 包括由以下瞻博网络组件组成的独特组合:

- 基于 Marvis 虚拟网络助手构建的数据中心 AIOps

- 通过 Apstra Data Center Director 实现的多供应商网络自动化

- 经过 AI 优化的以太网功能,包括用于 IPv4/v6 的 RoCEv2、拥塞管理、高效负载平衡和遥测

通过对上述组件进行整合,Ops4AI 能够助力高性能 AI 数据中心加速实现价值,同时降低运维成本并简化流程。

客户可以在实验室中运行哪些 AI 模型?

瞻博网络 AI 实验室利用各种 AI 模型,包括:

- LLAMA2、LLAMA3

- BERT

- DLRM

- NCCL-TESTS 和 RCCL-TESTS

- 客户也经常自带模型 (BYOM)

客户可以运行标准模型(BERT、LLAMA、DRLM)进行基准测试和性能测试。此外,客户还可以自带模型,在由脊叶式网络拓扑结构组成、拥有轨道优化设计的瞻博网络验证设计 (JVD) 上试运行。我们也会在实验室中测试提交的 MLCommons 文件。

MLCommons 是什么?

MLCommons 是一个基于开放协作理念成立和发展的 AI 产业联盟,旨在改善 AI 系统。它帮助全球各地的公司和高校构建更出色的 AI 系统。

瞻博网络是第一家在 2/3 月初向 MLCommons 提交多节点 Llama2 推理基准的公司。最近,我们又提交了 MLPerf Training4.0 基准测试。我们致力于利用以太网构建开放的架构,来实现数据中心网络基础架构中的 GPU 互联。

实验室目前正在使用哪些产品?

- 瞻博网络 QFX 系列、PTX 系列,带 400G 和 800G 接口

- Apstra Data Center Director 自动化解决方案(高级)

- VAST 和 WEKA VAST 存储

- Nvidia GPU (H100、A100)、AMD GPU (MI300X)

AI 实验室的客户测试结果是否会被公开?

我们重视客户模型和测试数据的保密性和隐私性。因此,我们不会使用客户模型来与其他客户进行测试。虽然 MLPerf 模型公开可用,但客户模型不会被共享。

我是瞻博网络渠道合作伙伴。我应如何为客户获取访问实验室的资格?

请访问合作伙伴中心页面,以提交访问申请。

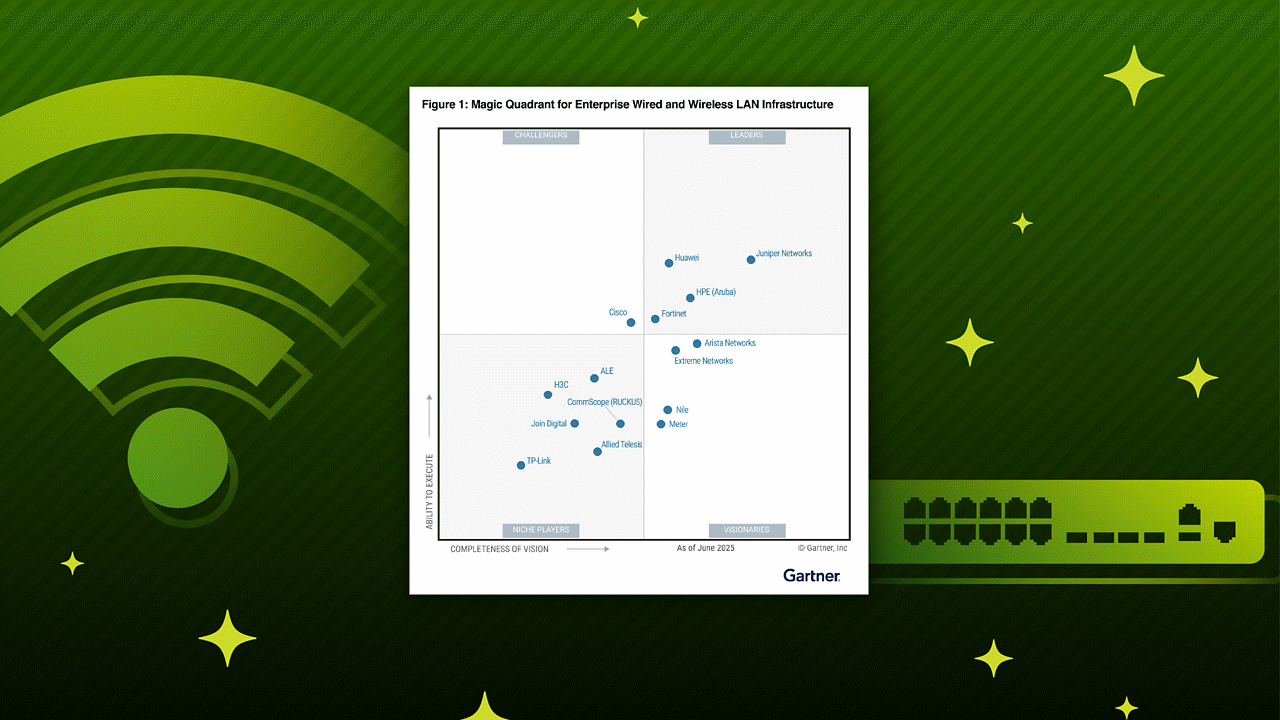

Gartner,《数据中心交换魔力象限》,作者:Andrew Lerner、Simon Richard 等,发布日期:2025 年 3 月 31 日

GARTNER 是 Gartner, Inc. 和/或其附属公司在美国及全球的注册商标和服务商标,MAGIC QUADRANT(魔力象限)是 Gartner, Inc. 和/或其附属公司的注册商标,经许可在此使用。保留所有权利。

本图表由 Gartner, Inc. 发布,系一份完整研究报告的一部分,应参照完整报告文档内容进行评估。您可以向瞻博网络索取该 Gartner 文档。

Gartner 不为其研究报告中描述的任何供应商、产品或服务背书,也不建议技术用户仅选择评级最高或获得其他称号的供应商。Gartner 研究报告由 Gartner 研究机构的观点构成,不应解释为事实陈述。Gartner 对本研究不作任何明示或暗示的担保,包括对于适销性或特定用途适用性的担保。