예: LDP 신호 LSP에 대한 MPLS TTL 전파 구성

개요

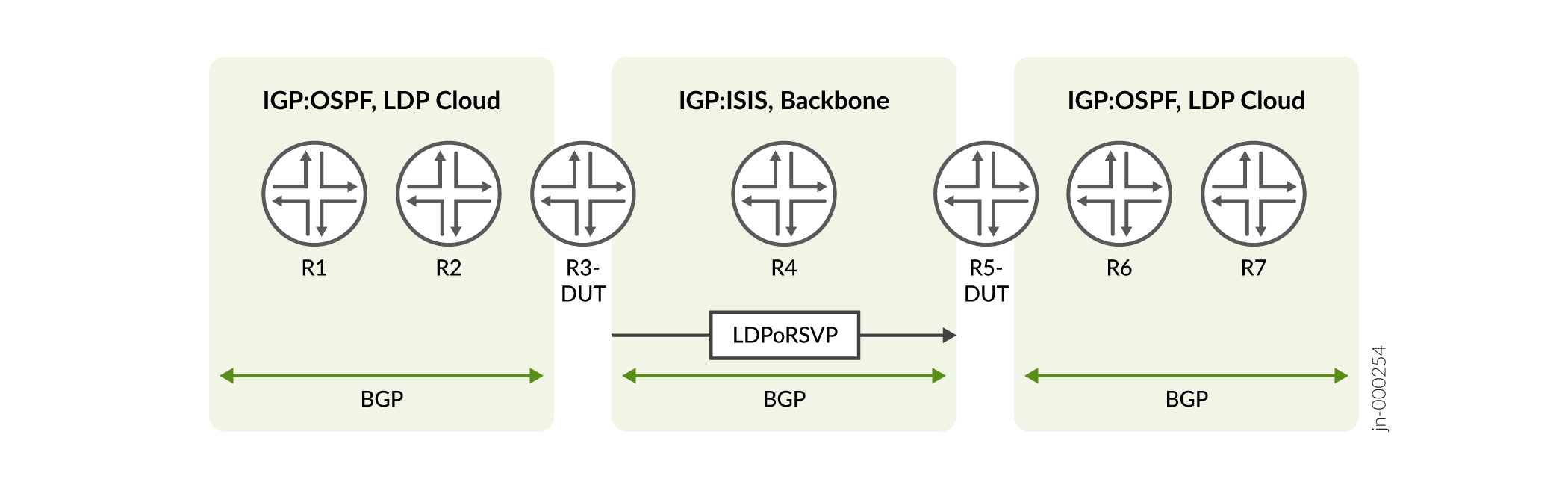

다음 그림에서는 계층의 문이 [edit protocol ldp] 유익한 일반적인 시나리오를 no-propagate-ttl 보여 줍니다.

토폴로지

그림에서 LDPoRSVP와 백본으로 연결된 두 개의 네이티브 LDP 클라우드를 볼 수 있습니다.

- 라우터 R1에서 패킷은 LDP 레이블로 캡슐화되어 대상 R7로 전송됩니다.

- 라우터 R3에서는 패킷의 LDP 레이블이 IP 패킷으로 제거됩니다. 그런 다음 패킷은 LDPoRSVP(LDP over RSVP)로 캡슐화되어 백본을 통해 전송됩니다.

- 라우터 R5에서 LDPoRSVP 레이블이 IP 패킷으로 제거된 다음 패킷이 다시 LDP 레이블에 캡슐화되어 대상으로 전송됩니다.

목적

목적은 다음 작업을 수행하는 것입니다.

- TTL 전파를 사용하지 않고 두 LDP 클라우드를 숨깁니다

- 백본 숨기기 해제(LDPoRSVP)

패킷이 라우터 R1에서 라우터 R7로 전송되면 이러한 작업은 두 라우터 R1 및 R5에서 수행되어야 합니다. 기존 옵션으로는 이 작업을 수행할 수 없습니다. 예를 들어, 라우터 R5에서 전역 옵션(set protocol mpls no-propagate-ttl)을 사용하면 역방향(R7-R1)의 TTL 전파 LDPoRSVP 백본이 비활성화됩니다. 이는 옵션이 LDP와 RSVP 모두에 적용 가능하기 때문에 발생합니다.

LDP에서 No Propagate TTL 및 Propagate TTL 동작의 사용 사례

라우터 R3의 LDP는 전파 TTL 없음과 전파 TTL 동작을 모두 지원해야 합니다.

LDPoRSVP가 있는 라우터 R3에서 R4 방향으로 라우터는 전파 TTL 동작을 지원해야 합니다. 그러나 네이티브 LDP(라우터 R2)의 경우 LDP는 전파 TTL 동작을 지원하지 않아야 합니다.

이 결과를 달성하기 위해 라우터 R3 및 라우터 R5에 대해 구성해야 하는 LDP 아래에 새로운 옵션을 no-propagate-ttl 도입했습니다. 이 옵션은 LDP 경로에 대한 TTL 전파를 비활성화합니다.

LDPoRSVP 시나리오에서 전파 동작은 RSVP no decrement TTL(no-decrement-ttl) 옵션에 따라 달라집니다.

- LDPoRSVP 시나리오에서 옵션을 구성하고

no-propagate-ttl감소 TTL(no-decrement-ttl)이 구성되지 않은 경우 TTL 전파가 발생합니다.몇 가지 예를 들면 다음과 같습니다.

라우터 R3에서 LDPoRSVP 시나리오의 경우 다음 구성을 설정하면 TTL 전파가 발생합니다.

user@host> set protocol ldp no-propagate-ttl

- 라우터 R3과 라우터 R5 간의 LSP를 통해 옵션을 구성

no-decrement-ttl하면 TTL 전파가 비활성화됩니다.예를 들어, 라우터 R3에서:

user@host> set protocol ldp no-propagate-ttl user@host> set protocol mpls no-decrement-ttl

라우터 R1에서 패킷은 CLI가 구성될 때 TTL 255의 LDP 레이블로 no-propagate-ttl 캡슐화됩니다.

라우터 R3에서:

- 패킷의 LDP 레이블은 IP 헤더로 제거되며, TTL은 LDP 레이블에서 IP 헤더로 복사되지 않습니다.

- 패킷은 LDPoRSVP 레이블로 캡슐화되어 백본을 통해 전송됩니다.

- 새로운 옵션은

ldp no-propagate-ttlno-decrement-tllTTL을 전파해야 하는지 여부를 결정합니다. no-decrement-ttl옵션이 구성되지 않았으므로 일반적인 TTL 전파가 발생합니다

라우터 R5에서 LDPoRSVP 레이블은 IP 헤더로 제거됩니다. 새로운 옵션은 LDP 프로토콜을 지원하도록 no-propagate-ttl 구성되며, IP 패킷은 TTL 255의 LDP 레이블로 캡슐화되어 전송됩니다.

구성

CLI 빠른 구성

이 예제를 빠르게 구성하려면 다음 명령을 복사하여 텍스트 파일에 붙여 넣은 다음 줄 바꿈을 제거하고, 네트워크 구성과 일치하는 데 필요한 세부 정보를 변경한 다음, 명령을 복사하여 [edit] 계층 수준에서 CLI에 붙여넣습니다.

set protocol ldp no-propagate-ttl

결과

TTL 구성을 표시하도록 CLI 명령 show ldp overview 의 출력을 수정했습니다.

구성 결과를 확인합니다:

user@host> show ldp overview Instance: master Reference count: 4 Router ID: 10.1.1.1 Inet LSR ID: 10.1.1.4 Inet6 LSR ID: 10.1.1.6 LDP inet: enabled LDP inet6: enabled Transport preference: Single-stack Message id: 21 Configuration sequence: 1 Deaggregate: disabled Explicit null: disabled IPv6 tunneling: disabled Strict targeted hellos: disabled Loopback if added: yes Route preference: 9 Unicast transit LSP chaining: disabled P2MP transit LSP chaining: disabled Transit LSP statistics based on route statistics: disabled LDP route acknowledgement: enabled BGP export: enabled No TTL propagate: enabled LDP mtu discovery: disabled LDP SR Mapping Client: disabled Capabilities enabled: none Egress FEC capabilities enabled: entropy-label-capability Downstream unsolicited Sessions: Operational: 2 Retention: liberal Control: ordered Auto targeted sessions: Auto targeted: disabled Dynamic tunnel session count: 0 P2MP: Recursive route: disabled No rsvp tunneling: disabled Timers: Keepalive interval: 10, Keepalive timeout: 30 Link hello interval: 5, Link hello hold time: 15 Targeted hello interval: 15, Targeted hello hold time: 45 Label withdraw delay: 60, Make before break timeout: 30 Make before break switchover delay: 3 Link protection timeout: 120 Graceful restart: Restart: enabled, Helper: enabled, Restart in process: false Reconnect time: 60000, Max neighbor reconnect time: 120000 Recovery time: 160000, Max neighbor recovery time: 240000 Traffic Engineering: Bgp igp: disabled Both ribs: disabled Mpls forwarding: disabled IGP: Tracking igp metric: disabled Sync session up delay: 10 Session protection: Session protection: disabled Session protection timeout: 0 Interface addresses advertising: 10.1.1.1 10.100.2.1 10.101.2.1 10.1.1.4 10.1.1.6 10.53.85.142 2001:db8:1000:1:2::1 2001:db8:1001:1:2::1 2001:db8:1111::1 2001:db8:abcd::128:53:85:142 fe80:1:2::1 fe80:1001:1002::1 LDP Job: Read job time quantum: 1000, Write job time quantum: 1000 Read job loop quantum: 100, Write job loop quantum: 100 Backup inbound read job time quantum: 1000, Backup outbound read job time quantum: 1000 Backup inbound read job loop quantum: 100, Backup outbound read job loop quantum: 100 Label allocation: Current number of LDP labels allocated: 4 Total number of LDP labels allocated: 7 Total number of LDP labels freed: 3 Total number of LDP label allocation failure: 0 Current number of labels allocated by all protocols: 4